数智融合丨研究洞察

核心摘要:

VUCA时代,市场变化加速。企业需要更加敏捷而准确的数智化决策,这些决策应当是分钟级的而非天级的,应当是基于全量数据的而非局部数据的,应当是基于准确数据的而非基于“脏数据”的,应当是业务人员和数据分析人员任意发起的而非是通过复杂流程和多部门配合才能实现的。

传统的数仓或者湖仓分离架构让数智融合和企业敏捷决策变得困难:数据孤岛存在,决策无法基于全量数据;数据来回流转,成本高、周期长、时效差。基于存储-缓存-计算分离,湖-仓-AI数据统一元数据管理的Serverless,可在数据量、成本、效率、敏捷方面取得最优解。

开源为数智生态贡献重要力量,但这不预示所有企业需通过开源产品自建数智平台。实际上,大多企业聚焦自己核心业务,选择性能稳定、无须运维、数智融合、端到端自动化与智能化的商业化数智平台,ROI会更高。当然,平台应与主流开源产品具有良好继承性,如此,更加灵活开放,企业的IT人才补给成本也更低。

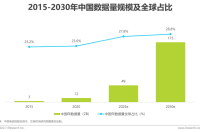

数据量和非结构化数据占比上升

统一管理,统一查询使用,成为新的挑战

全球数据量以59%以上的年增长率快速增长,其中80%是非结构化和半结构化数据,中国数据量的上升较全球更为迅速。 数据量和非结构化数据的上升,使得基于对象存储的数据湖越来越为普及。此时,如何使用统一管理,统一查询使用,成为新的挑战。

数据多源异构成为常态

数据从“汇聚才可被用”到“链接即可被用”

在传统数仓中,多源数据经ETL过程并集中入仓,方可被使用。该方式有许多不足:第一,因有复杂的ETL过程及大量数据的传输,数据实时性难以保障,因此分析常必须T+1才可完成;第二,数据的全量存储和存储成本之间难以取舍,因此必须提前抉择保留哪些数据,随着数据种类的逐渐增多,这很难做到;第三,对于异常值的下钻、回溯等,无法回溯到最为原始的数据。随着应用场景的增多,数据库的种类也逐渐丰富,如更适应物联网场景的时序数据库、更适应知识谱图应用的图数据库,等等。

综上,多源异构、分布存储、现用现传、统一查询与应用的架构,逐渐被敏捷型企业认可。

大数据的5V价值有待进一步释放

可从平台性工具入手,进而解决思维和技能的问题

大数据产业作为以数据生成、采集、存储、加工、分析、服务为主的战略性新兴产业,提供全链条技术、工具和平台,孕育数据要素市场主体,深度参与数据要素全生命周期活动,是激活数据要素潜能的关键支撑,是数据要素市场培育的重要内容。目前,大数据产业仍存在数据壁垒突出、碎片化问题严重等瓶颈约束,大数据容量大、类型多、速度快、精度准、价值高的5V特性未能得到充分释放。这其中既有思维、技能的要素,又有工具的要素,三者也并非割裂存在,一般来说,性能稳定、简单易用的全链条平台工具有助于消除思维的“不敢”和技能的“不会”,化解掉5V特性释放的原始阻力,使得大数据更加普适化。

云原生:从微服务走向Serverless

从PaaS到FaaS,基础设施被更深层次地托管和“屏蔽”

当前,微服务的生态和实践已经比较成熟,其设计方法、开发框架、CI/CD工具、基础设施管理工具等,都可以帮助企业顺利实施,然而其仍有许多不足: (1)粒度仍然比较大。(2)开发仍有较高门槛。(3)微服务基础设施管理、高可用和弹性仍然很难保证。(4)基础设施的成本依然较高。 而Serverless中,开发者不再需要将时间和资源花费在服务器调配、维护、更新、扩展和容量规划上,这些任务都由平台处理,开发者只需要专注于编写应用程序的业务逻辑。如果再结合低零代码,则 “编写应用程序”的难度也大为降低,企业内的技术人员更加贴近业务。

人工智能:需要大规模准确数据哺育

人工智能应用引发数据治理需求

企业在部署AI应用时,数据资源的优劣极大程度决定了AI应用的落地效果。因此,为推进AI应用的高质量落地,开展针对性的数据治理工作为首要且必要的环节。而对于企业本身已搭建的传统数据治理体系,目前多停留在对于结构性数据的治理优化,在数据质量、数据字段丰富度、数据分布和数据实时性等维度尚难满足AI应用对数据的高质量要求。为保证AI应用的高质效落地,企业仍需进行面向人工智能应用的二次数据治理工作。

业务敏捷需要IT架构“去过程化”

通过抽象解耦、水平扩展、自动化与智能化实现去过程化

VUCA时代,市场变化加速,通过数据来分析和决策的需求,也有了更高的不确定性。当这些需求提出,通过一套复杂的IT流程和漫长的等待,变得不再现实,IT架构的去过程化变得极为重要。去过程化是指减少或完全去掉原始数据/原子能力与业务需求之间的中间数据/步骤,或使中间数据/步骤无须人为干预,自动化、智能化完成。其可实现架构的简单化、扁平化,同时可对业务需求实时响应,以进一步实现敏捷和创新。架构一开始就放弃“精细梳理方可使用”以及“梳理完成千万别动”思想 ,用全量原始数据保障读时模式,有助于打破“僵”与“乱”的悖论,使得企业用更少的“能量” 便可以维持数字化系统的持续运行。

痛点一:数据量-成本-效率难以兼得

不可能三角需要更高维的技术去打破

在传统架构中,数据量、存储成本和计算效率是一组不可能三角。如果不考虑数据量和数据类型,那么一个传统的数仓或者单体的DBMS即可满足;不考虑计算效率,那么基于HDFS或者公有云对象存储即可满足,当下价格仅约0.1元/G/月,并持续下降,归档存储等价格更低;不考虑存储成本,可使用非易失性存储,其拥有一般硬盘的无限容量和断电保护特性,却有接近于内存的性能。

应对一:存储-缓存-计算三层分离

以内存为中心的架构,在大数据量下降低成本、保持性能

为了使数据充分共享,降低均摊成本且打破数据孤岛,存算分离架构产生,存储和计算各自弹性伸缩,按需使用。但此时,因存储拉远,IO成为瓶颈,性能有所下降,因此需要缓存层来存储高IO的热数据,并最终形成以内存为中心的架构。

从必要性看,以计算为中心架构已经无法适应当前数据生态发展:数据方面,大数据、人工智能等以数据为中心的工作负载快速发展;云方面,数据湖存算分离架构存储访问性能低,不支持实时分析。从可行性看,介质、网络、协议的高速发展驱动架构转型:SCM填补了内存纵向扩展的介质空白;缓存一致性标准的争夺进入白热化;高速内存直连协议及技术(如华为1520,InfiniBand,Converged Ethernet)使得内存的远程直接访问不再是障碍。

痛点二:仓-湖-AI数据形成新孤岛

要么隔离,要么迁移,均无法适应全量、敏捷、低成本需求

数据分析和AI分析经过多年的发展,出现了很多面向不同任务的专用数据系统:数仓系统处理结构化数据,规模不够大;基于对象存储的大数据系统处理海量数据和非结构化数据;AI系统一般是数据存储在本地。这些专用系统要么无法打通,形成新的数据孤岛,要么不同业务的开发要迁移数据,耗费存储和网络资源,数据准备慢、等待周期长,且面临后期数据不一致的风险,发现异常时数据的下钻、溯源等也相对困难,无法适应市场环境快速变化下敏捷数据分析的需求。

应对二:统一元数据到中心节点

Master-Slave架构,以集中管理代替集中存储

把数仓、数据湖、AI数据的目录、数据权限、事务一致性、多版本管理等能力都统一到一个中心点,依赖于这个中心点来访问数据,这样数据的利用就不会被孤立的系统束缚。这种分布式存储,统一管理的Master-Slave架构,类似于计算领域的Mapreduce。这种方式:首先,可以打破数据孤岛、让一份数据在多个引擎间自由共享,例如同一个表格可以被不同的分析工具做分析,既可以跑数仓任务,也可以做大数据和机器学习任务,不同的用户角色不管用什么工具访问数据,都有一致的权限,一致的事务控制;其次,可以避免数据来回迁移而造成资源的浪费;再次,任何环节都可以看到自己权限下的全量数据,例如ML工程师可以利用整个数据湖的数据做特征训练;最后,所有模型均基于唯一事实来源(原始数据),避免不同团队基于不同数据分析造成结果不一致,且一旦发现异常可以便捷地下钻、回溯。

痛点三:开源产品丰富,但开发运维难

开发成本高,运维成本高,技术与时俱进难,风险大

尽管在云、数、智体系下,开源产品极为丰富,但企业安全、稳定地驾驭,TCO并不低。 在开发上 ,企业一般需花费20-1000人力年的时间,不能满足业务敏捷性; 在运维上 ,人工运维,事后补救,宕机频繁,耗时耗力; 在技术更新上 ,开发人员难以与时俱进,资源浪费严重; 在IT风险上 ,企业将面对IT团队自身的风险(复杂架构下,团队离职无人接手)以及开源产品的漏洞风险(如log4j4漏洞事件),还可能面对因经验不足选型错误的风险; 在体验上 ,因产品自产自用,复用率低,技术团队一般只保障基础需求,对于降低业务人员使用难度、提升使用体验的附加性需求响应度低。并且,这些基础的开发、运维等,与企业核心业务常无必然联系,并不会带来企业核心竞争力的提升,导致企业数智化的ROI较低。

应对三:DataOps和MLOps融合

享受成熟产品的红利,兼顾与开源产品的继承和包容性

企业在数智化选型中,应首先明确自身的核心竞争力和能力边界,摒弃“重即好”思想,以更加轻盈的Serverless、Lowcode/Nocode、SaaS等方式享受社会分工和先进技术的红利。以数智融合为例,抛开IaaS层,企业自研还需掌握Kubernetes+Docker生态、Java+Hadoop生态、Python+Pytorch/Tensorflow生态、SQL生态……即便成功对接,往往也离好用、敏捷相去甚远,最终往往只形成指标长期不变的静态报表。而与此同时,业界已存在较为领先的一站式数智平台,让数据工程师甚至业务人员以简单、熟悉的工具/语言,甚至拖拉拽即可在全域数据内使用预置AI算法,打通大数据和人工智能,使得DataOps和MLOps融合,使数据和模型的开发成本大为降低,周期大为缩短。

企业选择基于开源产品自研,不少时候是出于一种怕被“绑架”的防御心态,以化解供应商倒闭或涨价等风险。为此,企业可从供应商综合实力,与开源产品的包容度和继承性等方面综合考虑,做到可组可分,灵活装配。

痛点四:数据准备工作复杂低效

数据长生命周期决定了其复杂性

数据质量至关重要,错误数据致使企业做出错误决策。数据的生成、采集、存储、加工、分析、服务、安全、应用长生命周期,使得数据的准备工作复杂、低效。例如,数据工程师开发大量的ETL任务,依赖大量算力资源,运行成本高,作业管理复杂,时间周期长,而此时数据分析师和AI开发者都需要等待ETL任务执行完,才能做相应的分析工作和建模工作。Cognilytica调研显示,机器学习中,超过80%的时间都用于数据的准备,预示着大量的数据工作其实与企业的经营目标并不相关,只是不得以而为之。并且,当任务不能便捷地执行和即时的反馈,偏业务侧的数据分析师常主动放弃“不太重要的”需求和对数据的深入探索。显然,这些都不符合企业数智化转型的真正目标。

应对四:端到端的自动化与智能化

低零代码实现自动化,AI反哺数据实现智能化

实现数据应用的敏捷化和去过程化,需要在整个数据链条的端到端实现自动化和智能化。自动化一般用低/零代码实现:一方面可以屏蔽软硬件差异和复杂的底层技术,以便于理解的拖拉拽和少量代码,来降低使用门槛;另一方面,可以基于规则,配置自动化的工作流,以ifttt的方式减少重复工作量。智能化是指基于半监督或无监督的学习,自动发现数据管理中的规则,在Data4AI的同时,实现AI4Data,目前人工智能已经用于数据集成、数据质量、数据建模、数据安全与访问控制、数据关联、数据洞察等多个场景中。另外,低/零代码常和人工智能结合使用:将人工智能的统计意义上的规则,融入到低/零代码的逻辑化的流程中。